LLMOps

Lovelytics takes the complexity out of managing large language models, ensuring seamless deployment, optimization, and performance at scale. Our proven operational strategies streamline workflows, enhance reliability, and eliminate the friction that slows AI adoption.

Whether you’re using LLMs for automated customer interactions, text generation, or large-scale data analysis, our solutions ensure efficiency, governance, and improvement—so your AI initiatives deliver a measurable impact.

Key Components of Our LLMOps Offering

Data Preparation

We ensure LLMs are trained on high-quality, well-structured data for optimal performance. Our services cover data ingestion, cleaning, and transformation, laying the foundation for efficient and reliable model outputs.

Prompt Engineering and Management

Our experts design, refine, and optimize prompts to ensure LLMs generate accurate, relevant outputs. Using MLflow’s intuitive interface, we iteratively test and improve prompts, reducing risks like hallucination and data leakage while enhancing model reliability.

Fine-Tuning and Continuous Pre-training

We fine-tune pre-trained LLMs with domain-specific data, enhancing their accuracy for specialized tasks. Through continuous pre-training, we keep models updated with industry-specific insights, ensuring they remain relevant and effective.

LLM Chaining and Orchestration

We apply LLM chaining to sequence multiple model interactions, simplifying complex tasks to manageable steps while improving accuracy and efficiency.

Model Deployment and Monitoring

Our LLMOps services enable seamless deployment across on-premises and cloud environments, ensuring scalability and reliability. We provide continuous monitoring to detect and mitigate model drift, performance issues, and operational inefficiencies.

Real-Time Feedback and Oversight

We integrate human-in-the-loop systems to provide real-time feedback and continuous improvement for your LLMs. This approach is essential for high-accuracy, context-driven applications, ensuring models evolve and adapt to meet dynamic business needs.

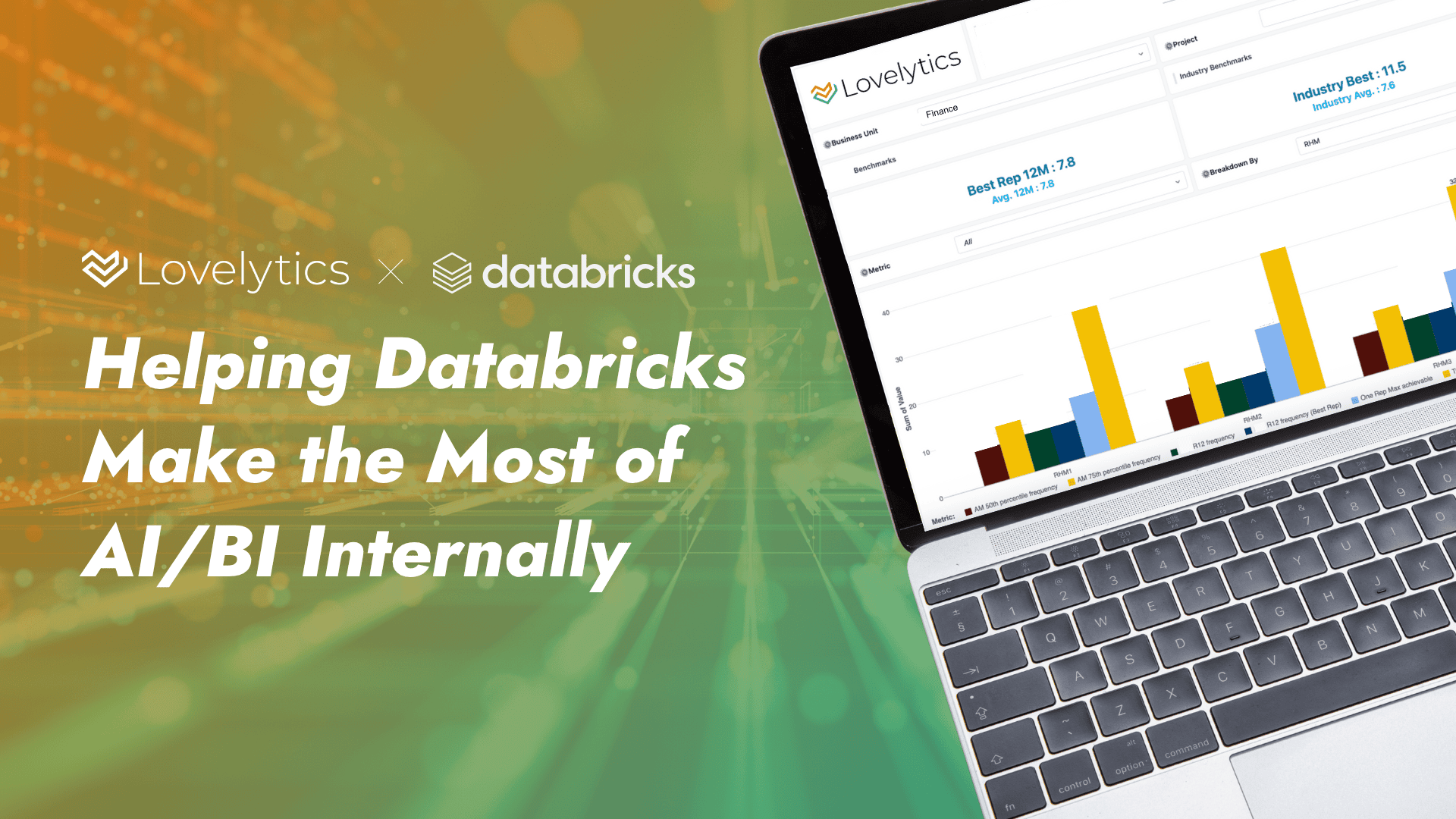

MLflow and Databricks Integration

Lovelytics’ LLMOps services are tightly integrated with Databricks and MLflow, offering a unified environment for managing your LLMs.

From data preparation and model training to deployment and monitoring, our services provide the infrastructure and tools needed to operationalize LLMs at scale.

Deploy models directly within Databricks’ cloud infrastructure, ensuring that your LLMs handle high-performance inference tasks efficiently.

We utilize Databricks and MLflow to automate the training, testing, and deployment of models. This automation ensures that your models are continuously updated and deployed with minimal manual intervention, maintaining their accuracy and relevance.

MLflow’s evaluation tools and AI Gateway provide robust model assessment, governance, and centralized management, ensuring that your LLMs are secure, compliant, and optimized for performance.

Featured Insights

Start Your Journey Toward Data-Driven Success

Let Lovelytics be the catalyst for your data-driven journey, delivering solutions that perfectly align with your unique ambitions and the visionary goals of tomorrow. Contact us today